Mit Datadrom den Datenstrom beschleunigen

Artikel in ICT kommunikation 1.9.2012

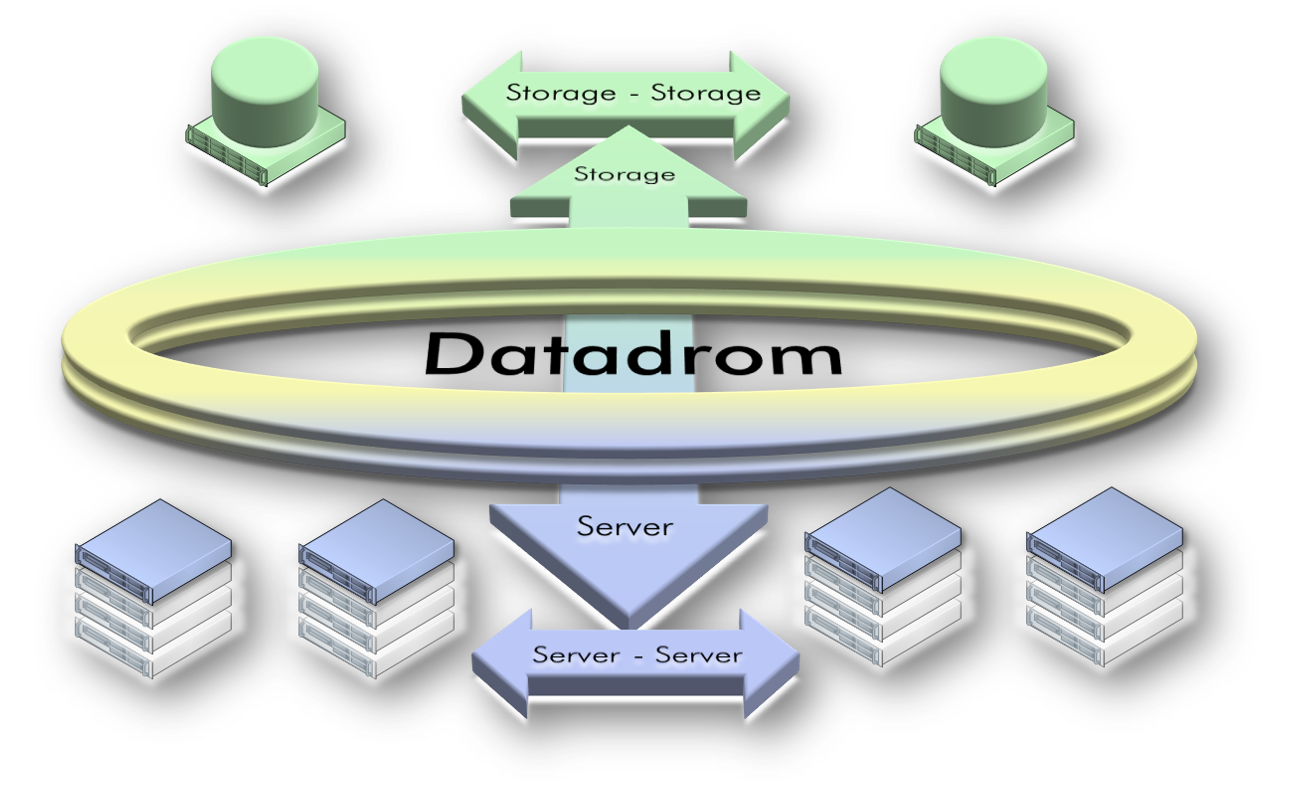

Server- wie Desktop-Virtualisierung verlagern den Datenverkehr zunehmend zu Server-Server. Das klassische Verkehrsvolumen von Server-Client nimmt ab. Der Datenfluss ist daher neu auszubalancieren. Dabei noch den Storage miteinzubeziehen, kann mehr aus den Investitionen machen.

Die steigende Komplexität hinter den Kulissen birgt mehrfach Risiken in sich. Je nachdem wie sie begriffen und in ihrem Konstrukt erfasst wird, resultieren weitreichende Konsequenzen. Sich ihr zu entziehen und sich auf den gerade fraglichen Fokus zu beschränken, führt meist zu kostspieligen Suboptimierungen. Die Industrie ihrerseits verspricht verlockend, dem Anwender die Komplexität auf einen Schlag abzunehmen. Die dargebotene Hand nennt sich converged, flexible, unified usw. Infrastruktur. Sie gruppiert alle Komponenten in einem Rack und managt sie insgesamt, bzw. Cloud-mässig. Die ursprünglich offenen Systeme verwandeln sich so dank dem Managementteil rasch in eine rein Herstellergebundene Lösung. Ob dabei der Nutzen die pure Abhängigkeit von einem Anbieter überwiegt, beantwortet der längerfristig angesetzte Blickwinkel schlüssig.

Die IT weiss zwar um die Bedeutung des non-volatile Memory. Dennoch erscheint die Erkenntnis, dass sich Komplexität durch Segmentierung reduzieren lässt, oft als volatil. Beruhen nicht gerade die Converged- usw. Angebote auf der Akkumulation von Komplexität, die allein nur noch der Anbieter in ihrer Form beherrschen dürfte?

Um einerseits die Komplexität zu verringern und andererseits Suboptimierungen zu verhindern, erweist sich ein abstrahierendes Konzept als Verständnisgerüst. So entstand vor ein paar Jahren die A /B /C Data Pooling Architektur. Sie vereint die Aufgaben des Archiv, Backup und Cache als ganzheitliches Design digitaler Datenhaltung. Cloud-Storage kann dabei die Effizienz steigern, sofern er auf Internet-Technologien beruht. Das Cache-Subsystem umfasst die aktiven Daten des primären Speichers. Die Begriffswahl drückt aus, dass dieser Pool minimal zu halten ist. Dazu bieten sich Mechanismen wie HSM Hierarchical Storage Management oder noch besser ILM Information Lifecycle Management an. ILM schafft den Sprung über die reine Datenspeicherung hinaus zum Datenmanagement - dem absehbar nächsten Schritt.

Mittlerweile zeigt sich, dass der Bogen der ganzheitlichen Betrachtung über die digitale Datenhaltung hinaus zu spannen ist. Der Layer der Services, umfassend synchrone Spiegelung mit Zero-Failover/-Fallback sowie asynchrone Replikation mit/ohne Snapshots u.a.m., gehörte dabei schon immer zu den Kernaspekten. Aufgrund schlagartig gewachsener Anforderungen wie VDI ist neu die Acceleration des Datenflusses mittels SSD-Technologie hinzugekommen.

Dies wiederum bedingt, dass auch der Connectivity-Layer zwischen Storage und Server mit einzubeziehen ist. Dabei führt es jedoch völlig ins Abseits, einfach nur das Altgewohnte modernisieren zu wollen. Um an Effizienz zu gewinnen, bedarf es der Evaluation neuer Technologien und bewährter Lösungswege vergleichbarer Aufgabenstel-lungen.

- Innovationen grenzüberschreitend nutzen

Bevor jedoch überhaupt an Lösungswege zu denken ist, sind vorgängig der Bedarf zu analysieren und daraus Schlüsse zu ziehen, um Zielsetzungen und Servicelevels abzuleiten. Zur Sicherung der Geschäftskontinuität gilt mittlerweile die synchrone Datenspiegelung als Standard-Anforderung. Diese beinhaltet auch das unterbrechungsfreie Failover und Fallback bei Ausfall eines Datenspiegels. Ohne diese Funktionalität crashen konsolidiert alle virtuellen Server. Darüber hinaus ermöglichen solch synchrone Datenspiegel, jederzeit flexible Wartungsfenster zu schalten. Da die notwendigen Mechanismen jedoch das Antwortzeitverhalten für alle Anwender beeinflussen, verlangen sie nach minimalen Latenzzeiten beim Datenverkehr. Dazu wurde bisher auf dem Campus stets auf Fiber Channel gesetzt. Für entfernte Datenreplikationen kam aus Kostengründen meist Ethernet zum Einsatz.

Seit ein paar Jahren ist 10GbE verfügbar, das in seiner Ausprägung als Datacenter Ethernet verlustfrei und mit garantierter Bandbreite übermittelt. Ergänzend ist nun die Ver-sion mit 40GbE verfügbar. Ein Adapter mit zwei Ports ist bereits unter CHF 900.— erhält-lich, also zu einem Bruchteil eines 8Gb FC, dual Port Adapters.

Diese Effizienzsteigerung lässt sich auch für den Server Layer nutzen. Kann doch ein 40GbE Adapter mit zwei Ports 80 GbE-Interfaces ersetzen. Vor allem aber 80 Fehlerquellen auf zwei reduzieren! Und warum wurde das nicht schon lange auf diese Weise gemacht? Ganz einfach, die bisherigen Server-Architekturen haben nicht über adäquate IO-Möglichkeiten verfügt.

Erst mit der aktuellen Servergeneration, die mit PCIe 3.0 kommt, kann die dafür notwendige Bandbreite bereitgestellt werden, und zwar gleich mit rund 8GB/s je Steckplatz.

Aus der Server- und Desktop-Virtualisierung resultiert ein intensiver Datenverkehr zwischen den virtuellen Servern. Diese Kommunikation erfolgt wiederum über Ethernet. Der Datenfluss wurde bisher praktisch ausnahmslos über die LAN-Switches abgewickelt. Deren Latenzzeit von Port zu Port liegt in der Grössenordnung von mehreren Millisekunden und ist damit dem Leistungspotenzial der neuen Server nicht mehr angemessen, bzw. die gewonnene Transaktionsbeschleunigung zerrinnt unterwegs.

Seit einigen Jahren ist eine neue Generation von Hochleistungs-Ethernet-Switches auf dem Markt. Bereits 2008 ermöglichten sie, einen Linkpreis von CHF 1 200.— (Switch-, Adapter-Port, Kabel, Transceiver) zu erzielen. Mittlerweile sind gar Produkte erhältlich, die Port-Port Latenzzeiten von 230-250 Nanosekunden aufweisen. Damit lässt sich der Datenverkehr zwischen den Servern um den Faktor 10 bis 50 beschleunigen! Und erst noch preisgünstig: 64x 10GbE Switch zu knapp CHF 13 000.— oder 36x 40/10GbE Switch unter CHF 18 000.—. Damit wird ein völlig neuer Preis- / Leistungsmassstab vorgegeben, der für die traditionellen Ethernet- und Fibre Channel-Lösungen unerreicht bleibt.

Da ist es doch naheliegend alle diese Anforderungen in einem Zug innovativ zu erledigen. Das Datadrom macht nun nichts anderes, als mit weitwinkliger Betrachtung, geeignete Innovationen gleich für mehrere Disziplinen in Einem zu verwenden, also mehrfach zu rationalisieren. Dabei wird der Datenfluss zwischen Server-Server, Server-Storage und Storage-Storage in einem Hochgeschwindigkeitsnetz konsolidiert. Die aktuelle Server-generation mit PCIe 3.0 nutzt sowohl deren Latenzzeit von bspw. 250 Nanosekunden wie auch den Datendurchsatz von 2.88Tbps voll aus.

Das Datadrom verhilft so auch der Grundidee der Virtualisierung zur ersehnten Wiedergeburt: Nur mehr mit wenigen, fett konfigurierten, physischen Servern die Last vieler virtueller Server zu tragen und endlich die versprochene Effizienz zu ernten. Die Unzahl der vielen physischen Server mit ihrer beschränkten IO-Architektur lässt sich nun schrittweise wieder reduzieren, vor allem aber auch deren Management drastisch vereinfachen.

- Datadrom beschleunigt Datenfluss

Die Datadrom-Architektur nutzt längst bewährte Technologien aus dem Datacenter wie dem HPC High Performance Computing, bei dem die IO-Architektur aller Server in ei-ner gemeinsamen Low Latency Fabric zusammengelegt wird. Mit der Wahl von HPC-Produkten lässt sich vermeiden, teure und risikoreiche Umwege mit Angeboten in Kauf zu nehmen, die erst noch ins DC hinein wachsen wollen.

Das günstigste und schnellste Datadrom lässt sich auf der Basis von Infiniband (IB) realisieren. Für den kommerziellen Markt bleibt allerdings abzuwarten, bis Microsoft IB mit ihren neuen Serverspiegelungs-Technologien bekannt gemacht hat. Um die Komplexität gering zu halten, widerspricht es der Idee der Segmentierung, das Datadrom-Ethernet (DCE) mit dem LAN/WAN-Ethernet grundsätzlich zu verbinden - nur weil es gleich lautet? Wieso auch soll der LAN-Techniker zusätzlich noch das gesamte SAN Know-how beherrschen müssen und umgekehrt? Eine Zusammenlegung beider Spezialgebiete mündet daher in eine überproportionale Anhäufung von Komplexität aus.

Der klassische Client-Server-Verkehr nimmt aufgrund der fortschreitenden Virtualisierung laufend ab. Daher genügt i.d.R. die Weiterverwendung der bisherigen LAN-Infrastruktur. Ihr Ausbau wird sich allerdings am Preis-/Leistungsverhältnis der Low Latency Ethernet-Fabric messen müssen.

Wie schnell sich die unkritische Übernahme alter Schemas auf neue Technologien destruktiv auswirkt, belegt das Unterfangen, den RJ45-Stecker für 10GbE fit zu machen und auf Low Latency Switches zu portieren. Denn beim Vergleich identischer 10GbE-Switches, die sich nur durch die Up-to-date Implementierung mit SFP+ Technologie oder mit RJ45 (10GBaseT) unterscheiden, zeigt sich, dass das schöne „Ford T-Modell“ eine 4-mal höhere Latenzzeit sowie einen bis zu 50-mal höheren Stromverbrauch generiert. Und das nur, um rückwärtskompatibel zu GbE und Fast Ethernet zu bleiben und die übliche Distanz von 100m zu bewältigen. Doch gibt es dazu in der Praxis Anwendungsfälle? Welcher Arbeits-platz benötigt überhaupt 10GbE? – vor allem im Hinblick auf VDI. Sind, bzw. werden denn Arbeitsplätze mit CAT7-Verkabelung erschlossen?

Bei 40/10GbE handelt es sich um Datacenter-Technologie, bei der aktive Komponen-ten direkt miteinander verbunden werden. Patchpanels erübrigen sich so. Abgesehen davon entstehen dadurch bei Hochgeschwindigkeitsübertragungen rasch Fehlerquellen, denen bis anhin mangels Testequipment noch nicht oder nur limitiert mit Messungen beizukommen ist.