Composable PCIe 4.0 Fabric

GPU-, FPGA-, NVMe-Pooling mit H3 PCIe 4.0 Chassis

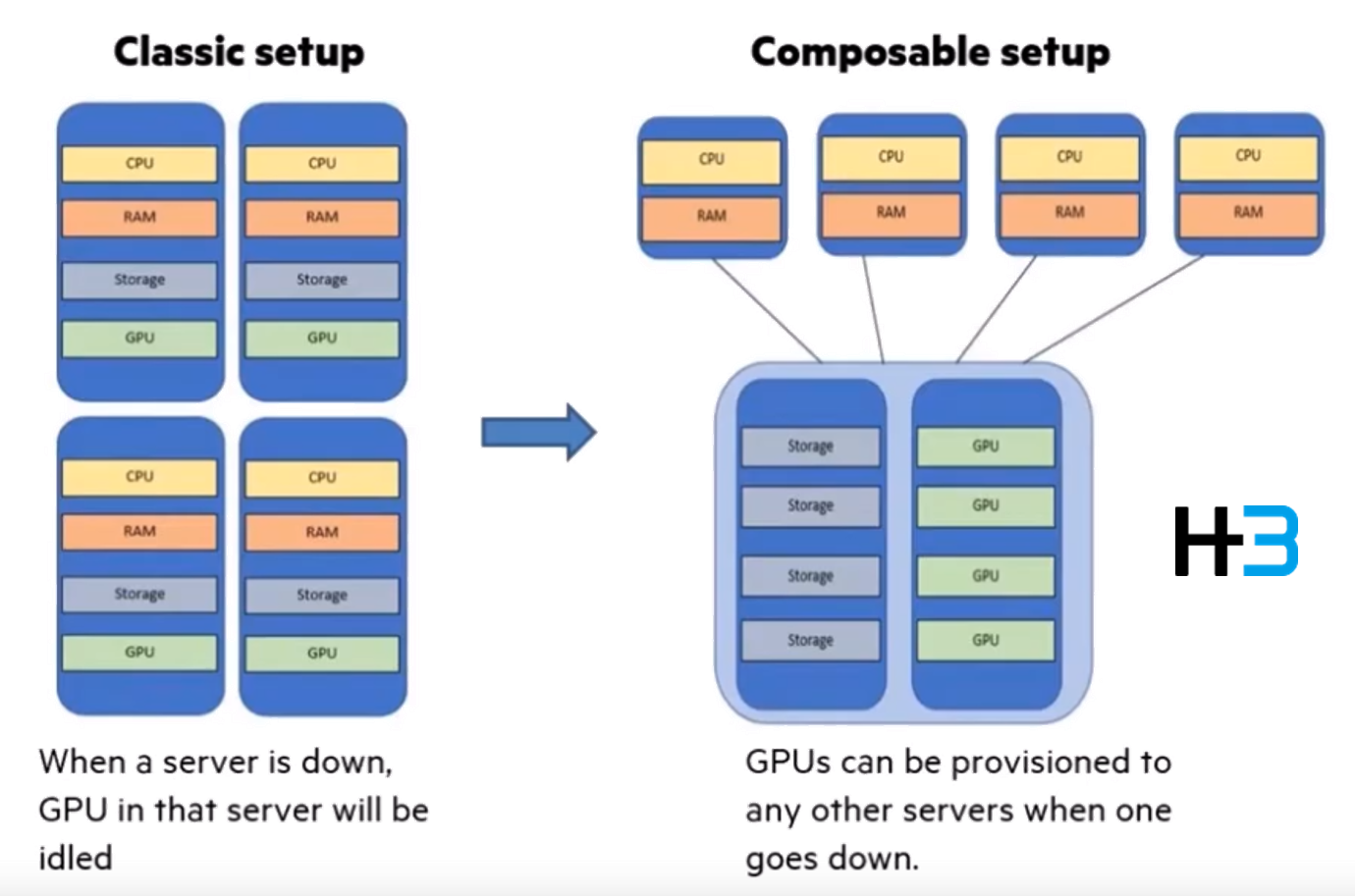

Mit dem Pooling von GPUs, FPGAs, Accelerators, NVMe u.m. lässt sich die Flexibilität der IT-Infrastruktur weiter steigern. Damit erhöhen sich Effizienz und Ausfallsicherheit.

ABC bietet dazu neu von H3 eine Palette von PCIe 4.0 Chassis an, die bis zu 16 GPUs oder andere PCIe 4.0 Boards fassen. Sie lassen sich von 1 bis 16 Hosts teilen.

Bis zu 8x NVIDIA RTX 3090 oder RTX A6000 u.a.m. können als vorteilhafte Chassis-Bundle bezogen werden. Die aktuellen Datacenter GPUs wie NVIDIA A100, A30, A40, A10, T4, A16, RTX 6000, RTX 8000 oder A16 sowie deren Vorgänger V100, P100 oder auch AMD MI50, MI60 etc. lassen sich mit den ensprechenden Stromkabeln in den Chassis nutzen.

Ebenso können Desktop GPUs der Quadro- und RTX-Linie für deren Sharing eingesetzt werden.

Double Width GPU wie RTX 3090 lassen sich mit bis zu 450W betreiben. Die Gehäuse sind für den problemlosen Betrieb thermisch optimiert. Sie bewähren sich in den Datacenter der bekannten Super-Scaler.

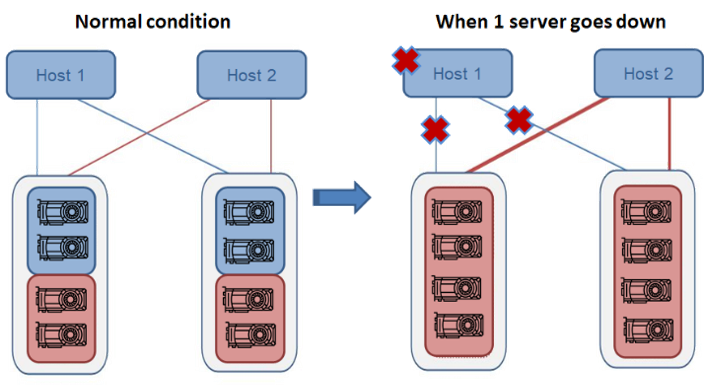

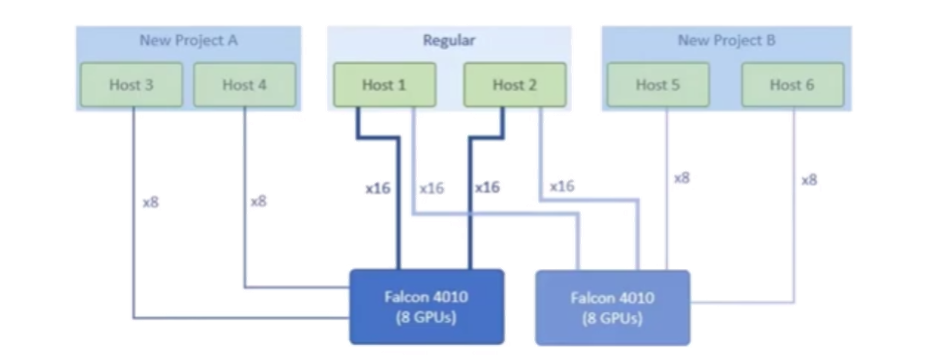

GPU Hochverfügbarkeit

Bspw. werden Host 1 und 2 jeweils mit einem Chassis via PCIe 4.0 x16 verbunden. Wenn Host 1 abwesend ist, werden die GPUs dem Host 2 zugeordnet. Kostbare Ressourcen bleiben so unabhängig vom Host jederzeit nutzbar. Die GPU-Auslastung erhöht sich zudem.

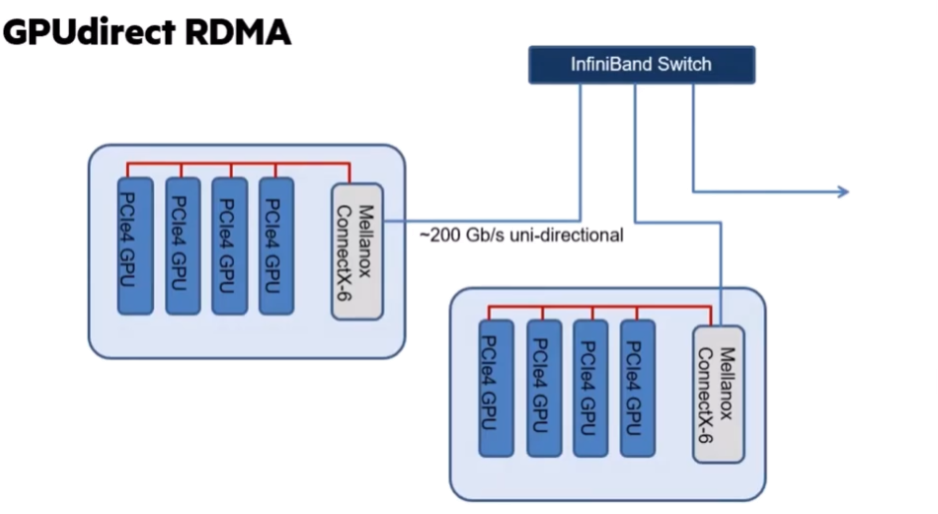

GPUdirect RDMA und DPU

Unabhängig vom Host kann Peer-to-Peer Kommunikation zum PCIe 4.0 x16 (<31.5GB/s) Durchsatz erfolgen. Selbst zwischen verschiedenen Chassis. Dies gilt auch für NVMe via DPU.

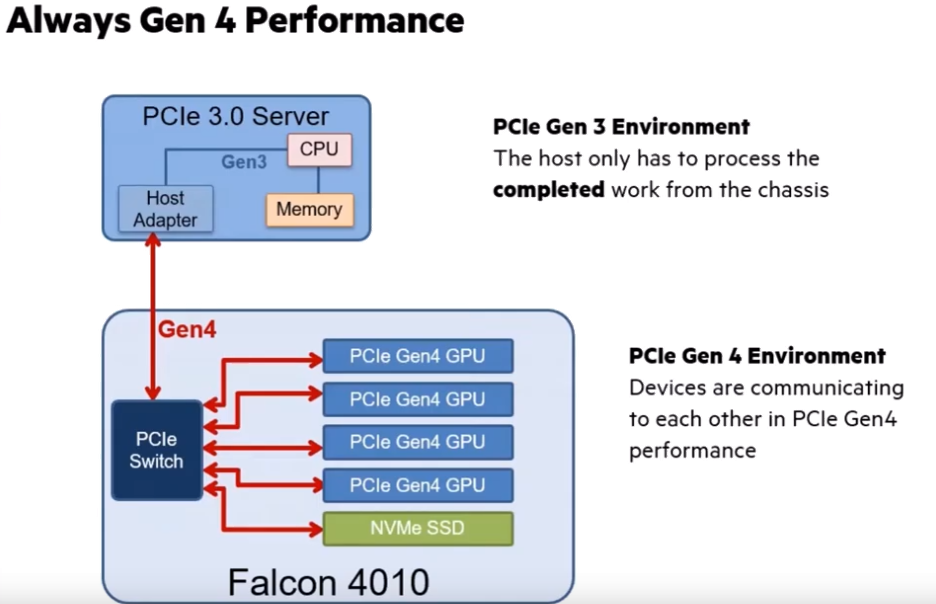

Gen 4 Leistung auch für PCIe 3.0 Umgebungen

Der Host muss nur die ausgeführten Jobs des/der Chassis weiter verarbeiten.

PCIe-Cluster nach Bedarf

Die PCIe-Ressourcen lassen sich Projekt-bezogen ganz nach Bedarf nutzen und erzielen so höchste Auslastung - just-in-time.

Je nach Bedarf und Anwendung kann aus einer Vielzahl von GPUs - auch in gemischtem Einsatz - gewählt werden:

- NVIDIA A100 für höchste Rechenleistung

- Deep Learning (DL) Training und Data analytics ≤ 8 GPUs

- DL Inference, batch und real-time ≤ 2 GPUs

- HPC High-Performance Computing und AI ≤ 4 GPUs

- Enterprise Acceleration für gemischte Workloads wie Grafik, ML, DL, Analytics, Training und Inference ≤ 2 GPUs

- Edge Acceleration für unterschiedlichste Anwendungen und Einsatzorte ≤ 2 GPUs

- NVIDIA A30 für Mainstream Computing

- DL Inference, batch und real-time ≤ 4 GPUs

- HPC High-Performance Computing und AI ≤ 4 GPUs

- Enterprise Acceleration für gemischte Workloads wie Grafik, ML, DL, Analytics, Training und Inference ≤ 2 GPUs

- Edge Acceleration für unterschiedlichste Anwendungen und Einsatzorte ≤ 2 GPUs

- NVIDIA A40 für höchste Grafikperformance

- Render Farms für batch und real-time Rendering ≤ 8 GPUs

- Beste Grafikleistung auf professionellen VDI ≤ 4 GPUs

- Cloud Gaming mit 4K Auflösung ≤ 8 GPUs

- Enterprise Acceleration für Grafik-intensive Workloads ≤ 2 GPUs

- Edge Acceleration für Grafik-intensive Workloads, AR / VR ≤ 4 GPUs

- NVIDIA A10 für Mainstream Grafik

- DL Inference, batch und real-time ≤ 8 GPUs

- Render Farms für batch und real-time Rendering ≤ 8 GPUs

- Beste Grafikleistung auf professionellen VDI ≤ 8 GPUs

- Cloud Gaming mit 4K Auflösung ≤ 8 GPUs

- Enterprise Acceleration für Grafik-intensive Rechen-Workloads ≤ 2 GPUs

- Edge Acceleration für Inference- und Video-Workloads ≤ 8 GPUs

- NVIDIA T4 – geringe Abmessungen, tiefer Energieverbrauch

- DL Inference, batch und real-time ≤ 8 GPUs

- Beste Grafikleistung auf professionellen VDI ≤ 8 GPUs

- Cloud Gaming mit 4K Auflösung ≤ 2 GPUs

- Enterprise Acceleration für ausbalancierte Workloads wie Grafik, ML, DL, Analytics, Training und Inference ≤ 4 GPUs

- Edge Acceleration für Inference- und Video-Workloads ≤ 8 GPUs

- NVIDIA A16 optimiert für VDI

- Beste Grafikleistung auf professionellen VDI mit höchstmöglicher Benutzerdichte ≤ 4 GPUs

- AMD Radeon Instinct™ MI50, MI60 (in Vorbereitung)

- NVIDIA Desktop GPUs

- Quadro GV 100, RTX 8000/6000/5000/4000, P2200/1100/620/400

- NVIDIA RTX A6000/5000/4000, T1000/T600/T400

- RTX 3090 u.a.m

- NVMe

- Intel® P4500, P4600, P4800X series

- Samsung PM1725a, PM1725b, PM1733 series

- Mellanox ConnectX®-4, ConnectX®-5, ConnectX®-6

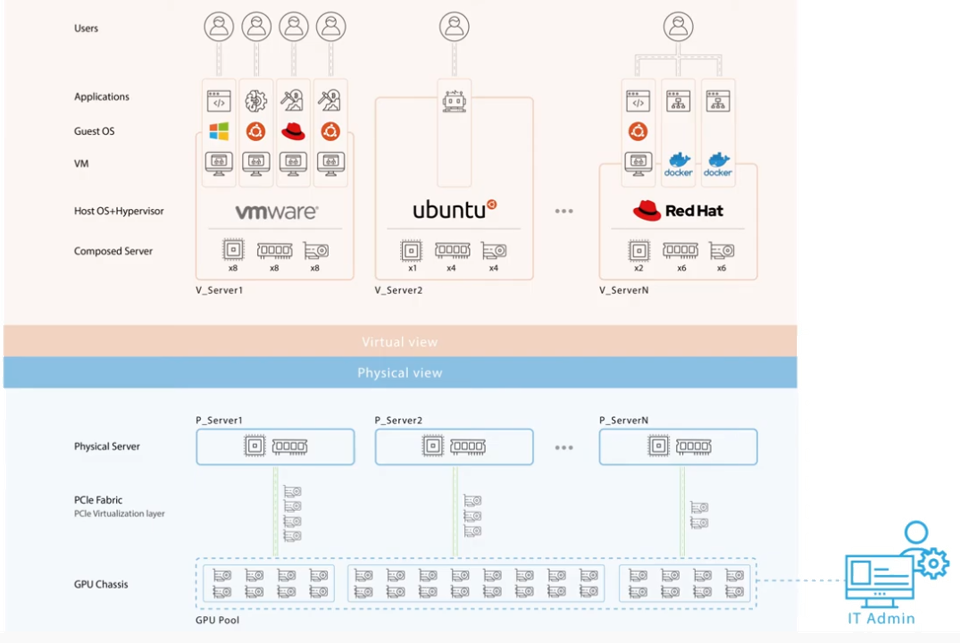

H3 PCIe-Fabric - virtuelle & physische Ebene

Der Cluster mit der H3 PCIe-Fabric umfasst eine virtuelle und physische Ebene:

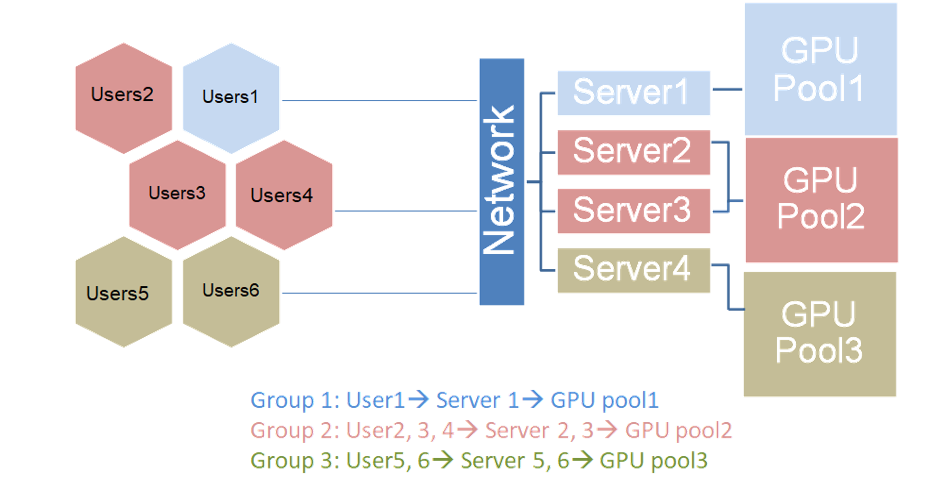

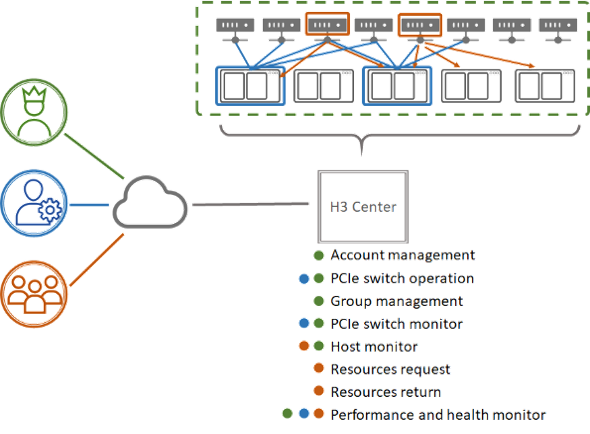

Multi-User und Chassis Szenario

Die Anwender können ganz nach jeweils aktuellen Bedarf und ihrer Präsenz beliebige PCIe 4.0 Ressorucen-Pools in den Chassis nutzen.

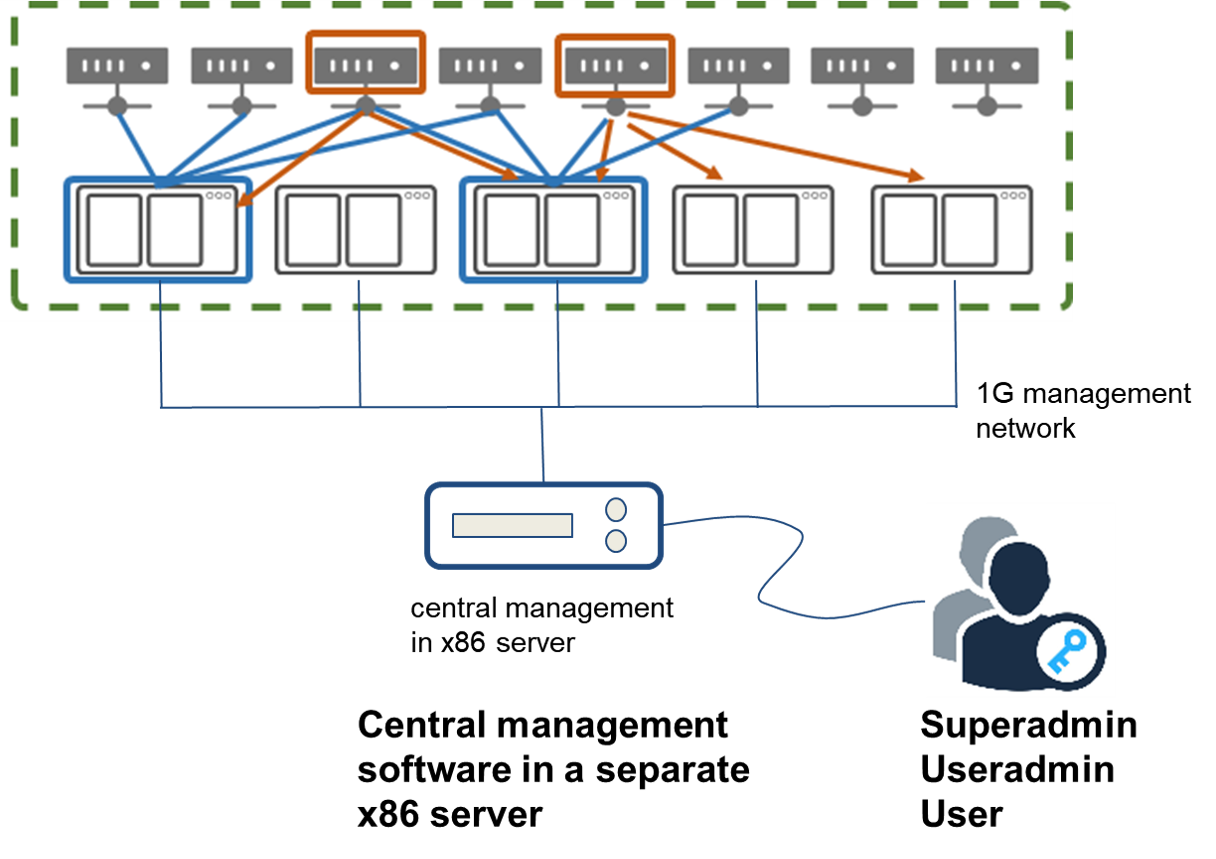

User Management

Das User-Management kennt 3 Rollen

- Superadmin: verwaltet alle Chassis und Konfigurationen

- User admin: verwaltet die Berechtigungen der Cluster-Gruppen

- User: verwaltet die zugewiesenen Maschinen

Zentrales Management

Das Management der User und PCIe-Fabric erfolgt über eine seaparte Konsole. Diese schliesst auch ein Dashboard mit ein. Es stellt die Übersicht über alle Ressourcen, deren Nutzung mit umfassenden Analysen sowie alle Leistungsdaten wie den detaillierten IO-Durchsatz bereit.